Больше не надо тратить время на дизайн и тексты писем. ИИ‑ассистент всё сделает сам.

Оживляем фото за 5 минут — с помощью нейросети

В коротких видео в 2026 году завирусился тренд: ИИ-видео с людьми, танцующими под популярные треки. Сделать такое видео самостоятельно очень просто: достаточно загрузить одну фотографию взрослого или ребенка, и нейросеть создаст видео, на котором человек будет двигаться в такт музыке.

Разбираем в статье, какой сервис используют для создания таких видео и как повторить этот вирусный тренд.

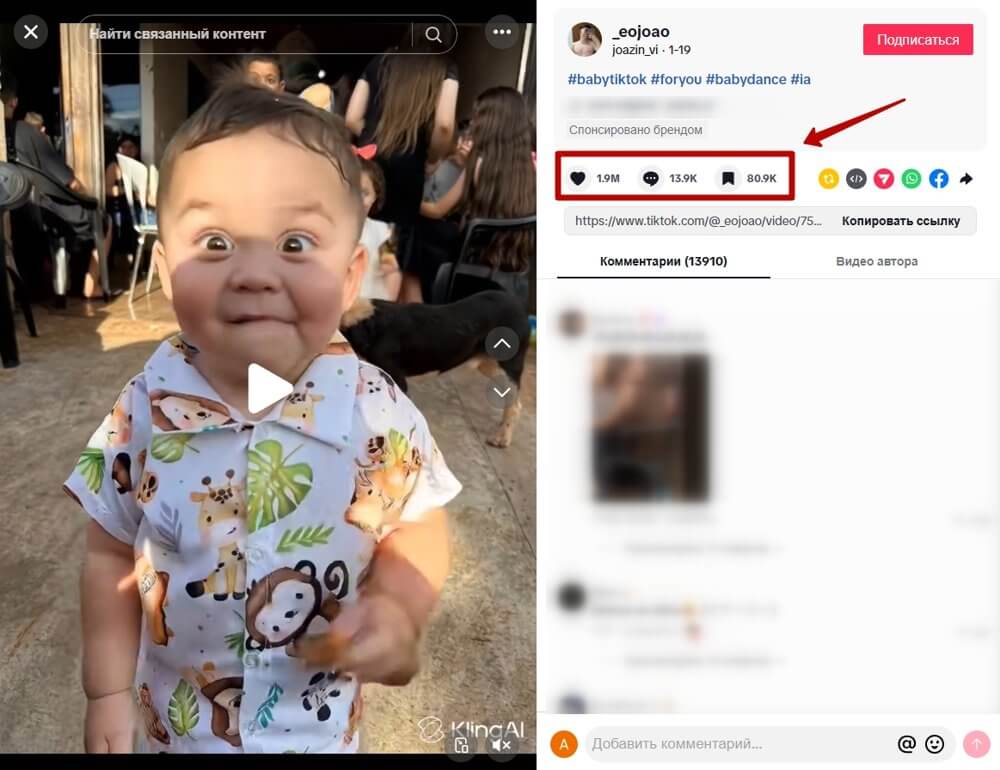

ИИ-танцы стали популярными под хэштегами #AIBabyDance, #AIDance. Они набирают в социальных сетях миллионы просмотров, лайков и тысячи сохранений.

Чаще всего используют уже известные танцы из TikTok и Reels: K-pop хореографию и вирусные челленджи. Нейросеть копирует эти танцы, накладывает на статичные фотографии и создает эффект «ожившего» снимка.

Для создания ИИ-танца понадобится фотография и нейросеть Kling. Сервис доступен в России, есть бесплатный лимит, которого хватает на 2-3 генерации в сутки.

Чтобы начать, перейдите на сайт Kling и выберите Video generation.

В меню нажмите на раздел Motion Control — это инструмент для создания анимации из статичных изображений.

Здесь находится две области, слева — для выбора шаблона танцевального видео, а справа — для фотографии, которую надо «оживить». Нужно открыть библиотеку готовых видео, для этого нажмите на Motion Library.

Справа появятся примеры видео, сгенерированных в Kling. Здесь можно найти примеры не только танцев, но и спортивных трюков, мимики.

Для генерации трендового видео выберите шаблон “Cute Baby Dance” или “Subject 3 Dance”.

После этого нажмите на раздел Add character image и добавьте свою фотографию. Лучше использовать снимки, где человек виден в полный рост или по пояс, так анимация получается более естественной. Подходит формат изображения JPG или PNG, весом не более 10 МБ.

В нижней части интерфейса можно выбрать разрешение видео 720Р или 1080Р, количество результатов генерации — от 1 до 4. Лучше оставить базовые настройки, чтобы не расходовать лимиты.

Под фотографиями есть текстовое поле, в который можно добавить промпт. Например, можно описать детали одежды, фон или стиль движений. Но при использовании готового пресета из Motion Library промпт необязателен — нейросеть сама анимирует фото.

Видео сгенерируется с той же музыкой, что и в референсе. Но если планируется наложить свою озвучку, можно выключить Audio. Чтобы создать видеоролик, нажмите Generate.

Генерация занимает примерно 5 минут, но если на сервисе высокая нагрузка, то процесс может занять больше времени. В результате появится видео, где герой фотографии исполняет трендовый танец.

Готовое видео можно скачать в формате MP4. Качество анимации зависит от исходного фото: чем четче изображение и лучше освещение, тем естественнее получатся движения. Если результат не устроил, можно попробовать другой снимок или шаблон.

После генерации стоит помечать такие видео как ИИ-контент. Платформы активно внедряют автоматическое распознавание ИИ-роликов, а непромаркированный контент может попасть под ограничения в охватах или модерацию.

В начале 2026 году стали популярны короткие видео, где нейросеть анимирует фотографию, на которой человек исполняет танцы из TikTok и Reels. Такой контент набирает миллионы просмотров за счет эффекта «ожившего» снимка.

Создать видео можно бесплатно в сервисе Kling: достаточно загрузить фото, выбрать готовый пример танца в Motion Library и запустить генерацию. Результат будет готов через 5–10 минут.

Читайте только в Конверте

Искренние письма о работе и жизни, эксклюзивные кейсы и интервью с экспертами диджитала.

Проверяйте почту — письмо придет в течение 5 минут (обычно мгновенно)