Токен — минимальная единица текста для нейросети. Это может быть слово, часть слова или символ. Например, слово «нейросеть» может быть разбито на 2-3 токена. Контекст в 128K токенов — это примерно 400-страничная книга.

VRAM — видеопамять вашей видеокарты. Чем больше VRAM, тем более крупную модель можно запустить. Для моделей на 7–14B параметров нужно минимум 8–16 ГБ VRAM, для 70B+ — уже 80+ ГБ.

RAM — обычная оперативная память компьютера. Если VRAM не хватает или вы запускаете модель на процессоре (CPU) без видеокарты, модель загружается в RAM. Но работать она будет гораздо медленнее.

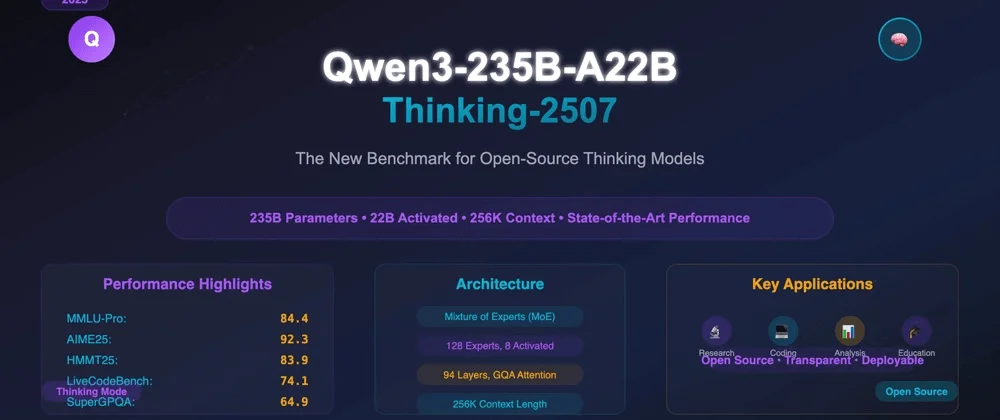

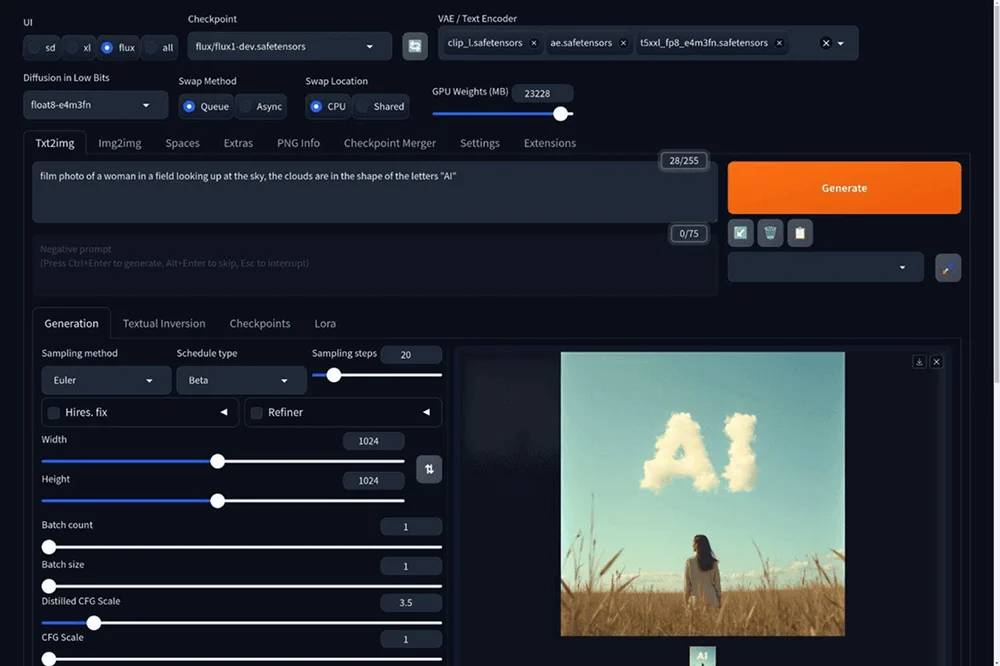

Квантизация — это сжатие модели за счет уменьшения точности вычислений. Например, квантизация int4 или FP8 позволяет ужать модель в 2-4 раза, почти не теряя в качестве. Благодаря квантизации даже большую модель теоретически возможно запустить но мощном ПК.

Кластер — это несколько компьютеров или серверов, объединенных в одну систему. Супермощные модели (типа DeepSeek V3 на 671B) нельзя запустить на одном компьютере — нужен кластер из нескольких машин с кучей видеокарт.

Мультимодальная модель — нейросеть, которая понимает не только текст, но и другие форматы: изображения, видео, аудио.

Fine-tuning — это дообучение уже готовой модели под конкретные задачи. Например, можно взять модель нейросети и дообучить ее на своих корпоративных документах, чтобы она лучше понимала специфику вашего бизнеса.

Chain-of-thought (цепочка мыслей) — режим, когда модель не просто выдает ответ, а показывает пошаговый процесс рассуждений. Полезно для сложных задач, где важно понять логику решения.

А теперь поговорим про сами нейронки.

Мы в Сетке

Мы в Сетке