Клоакинг (cloaking) — это метод подмены контента, который видит посетитель при переходе на сайт. С английского cloaking переводится как «скрывать, маскировать». Обычные пользователи и поисковые боты при посещении одной и той же страницы видят разную информацию.

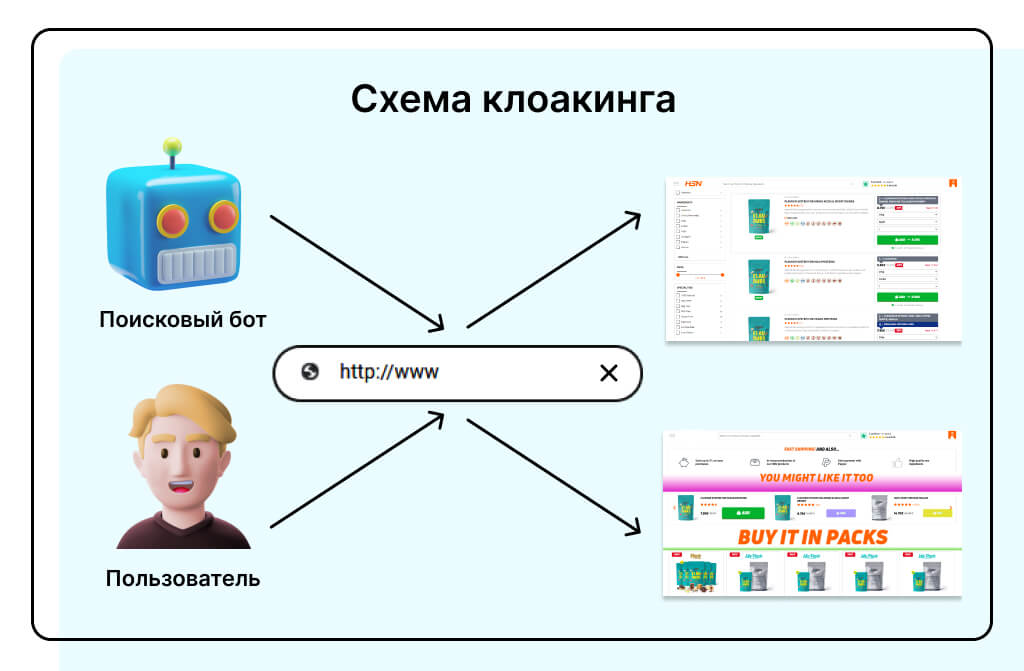

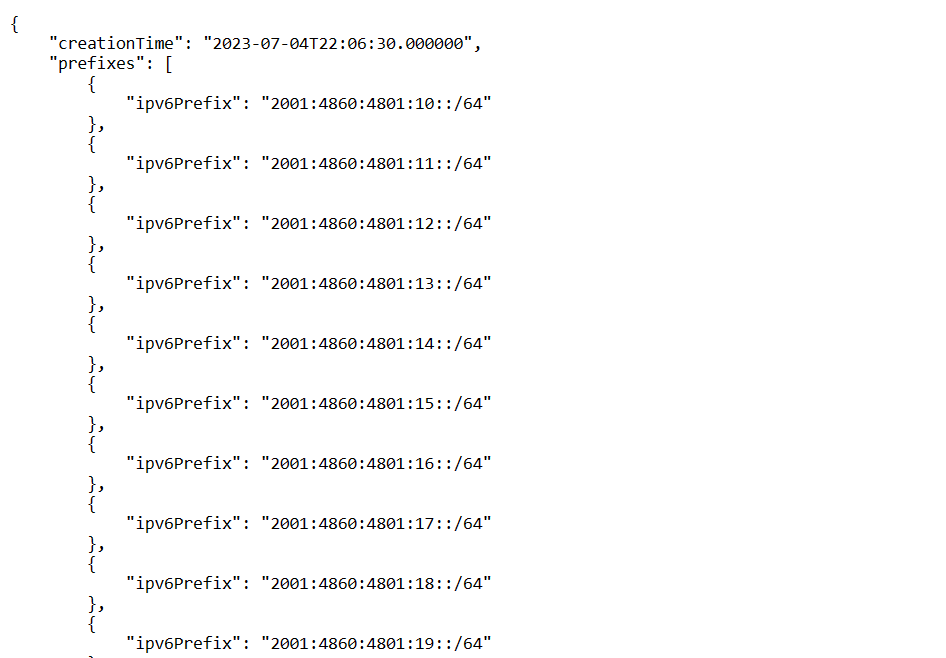

Трафик при клоакинге распределяется по разным страницам, исходя из характеристик посетителя

Например, рекламодатель планирует продвижение товаров для взрослых в социальных сетях. Модераторы отклоняют объявление. Тогда рекламодатель использует клоакинг. В этом случае при переходе по ссылке модераторов или алгоритмов откроется абсолютно другая страница. Она не будет связана с запрещенной тематикой. Другие целевые пользователи увидят ресурс, который был отклонен модераторами.

Чаще всего клоакинг используют, чтобы скрыть нежелательный или запрещенный контент от поисковых систем или анти-спам фильтров. Также cloaking применяют в SEO — демонстрируют поисковикам максимально оптимизированный ресурс.

Как работает клоакинг

Реализация клоакинга начинается с подготовки разных версий контента. В частности для продвигаемой страницы необходимо сделать:

- White page (белую страницу). Вайт пейдж содержит контент, который полностью соответствуют требованиям поисковых систем или рекламных сетей. Здесь размещают хорошие тексты и ключевые слова для лучшего SEO-продвижения. Именно эту страницу видят боты и модераторы.

- Landing page оффера (целевую страницу). Эту страницу видят обычные пользователи. Чаще всего ее используют для продвижения запрещенных товаров или мошеннических схем.

После подготовки нужных страниц настраивают разделение трафика. Вебмастер вручную задаёт условия показа актуальной целевой страницы в настройках сайта либо устанавливает фильтры в подключенном сервисе.

Если посетитель будет идентифицирован как пользователь-человек, то он увидит целевую страницу. Посетители-боты видят вайт пейдж.

Как поисковые системы относятся к клоакингу

Поисковые системы считают клоакинг одним из способов манипулирования поисковыми алгоритмами.

Правила «Яндекса» определяют клоакинг как «метод обмана поисковых систем, при котором посетителю сайта показывается одно содержимое страницы, а роботам поисковых систем — другое. … Некоторые вебмастера считают, что таким образом они смогут улучшить позиции сайта в результатах поиска, хотя, на самом деле, лишь подвергают свой сайт риску исключения страниц сайта из индекса поисковой системы»

Google признаёт клоакинг спамом по причине маскировки контента: «Сайты, которые нарушают наши правила, могут опуститься ниже в списке результатов поиска или вовсе там не показываться. … Под маскировкой подразумевается показ посетителям сайта и поисковым системам неодинакового контента с целью манипуляции позицией ресурса в результатах поиска и обмана пользователей»

За применение клоакинга поисковые системы понижают позиции ресурса. При повторных нарушениях сайт могут вовсе исключить из выдачи и/или заблокировать.

Отношение к клоакингу рекламных сетей

Использование клоакинга позволяет соблюсти требования рекламных сетей к контенту и продвигать продукты запрещенной тематики. Модераторы будут видеть вайт пейдж, которая полностью соответствует установленным нормам.

Практически все легальные рекламные сети, также как и поисковики, выступают против любых незаконных методов продвижения офферов.

В том числе клоакинг запрещён при арбитраже трафика в CPA-сетях. В случае выявления клоакинга аккаунт пользователя блокируют без возможности восстановления. При этом в большинстве случаев не имеет значения давность нарушения.

Какой бывает клоакинг

Выделяют два основных типа клоакинга:

Серый клоакинг (Gray Hat Cloaking). Технологию часто используют для увеличения трафика или продвижения страницы в поиске, например показывают поисковым ботам SEO-страницу с чрезмерной оптимизацией.

Серый клоакинг нарушает правила поисковых систем, даже если пользователям демонстрируют вполне полезный и качественный контент.

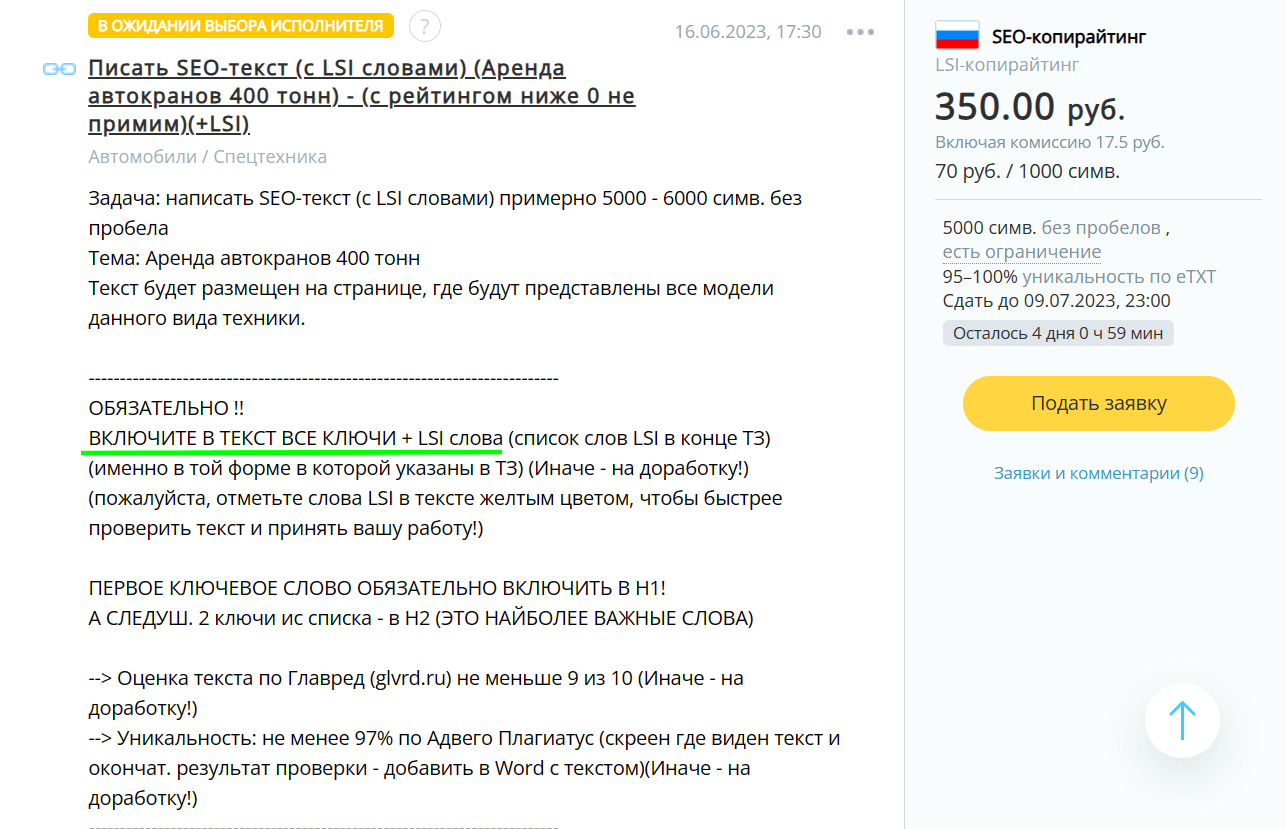

Так, на биржах копирайтинга нередко встречаются задачи на SEO-тексты со множеством ключевых слов. Такие SEO-тексты пишут не для людей, а для поисковых роботов.

Список обязательных ключей в этом ТЗ включает 350+ слов

Не советую использовать даже серый клоакинг для сайтов с разрешенными тематиками. Тут либо поисковики обнаружат подмену, либо конкуренты сообщат поисковикам через обратную связь о нарушениях сайта — и он будет понижен в результатах поиска, либо будут наложены санкции.

Черный клоакинг (Black Hat Cloaking). Этот вариант полностью нелегален. В то время как поисковики видят относительно приемлемый SEO-контент, пользователям обычно демонстрируют страницы с рекламой запрещенных препаратов, фишинговые сайты или мошеннические предложения.

Эта целевая страница продвигает подозрительный БАД под видом инновационного средства

Как настраивают клоакинг

Суть настройки клоакинга в том, чтобы разделить обычных пользователей и поисковых роботов. Сделать этом можно разными способами. Вот наиболее популярные.

User-Agent

User-Agent (агент пользователя) — это строка, с помощью которой веб-сервер идентифицирует клиента. User-Agent содержит следующую информацию:

- название браузера и его версию;

- операционную систему, на которой запущен клиентский браузер;

- устройство, на котором используется браузер (компьютер или смартфон);

- дополнительные характеристики — язык предпочтения пользователя, типы контента, которые клиент может обрабатывать.

Веб-серверы обычно используют User-Agent, чтобы адаптировать и оптимизировать контент для отображения посетителям. Например, показывать разные цены на товары в зависимости от геолокации.

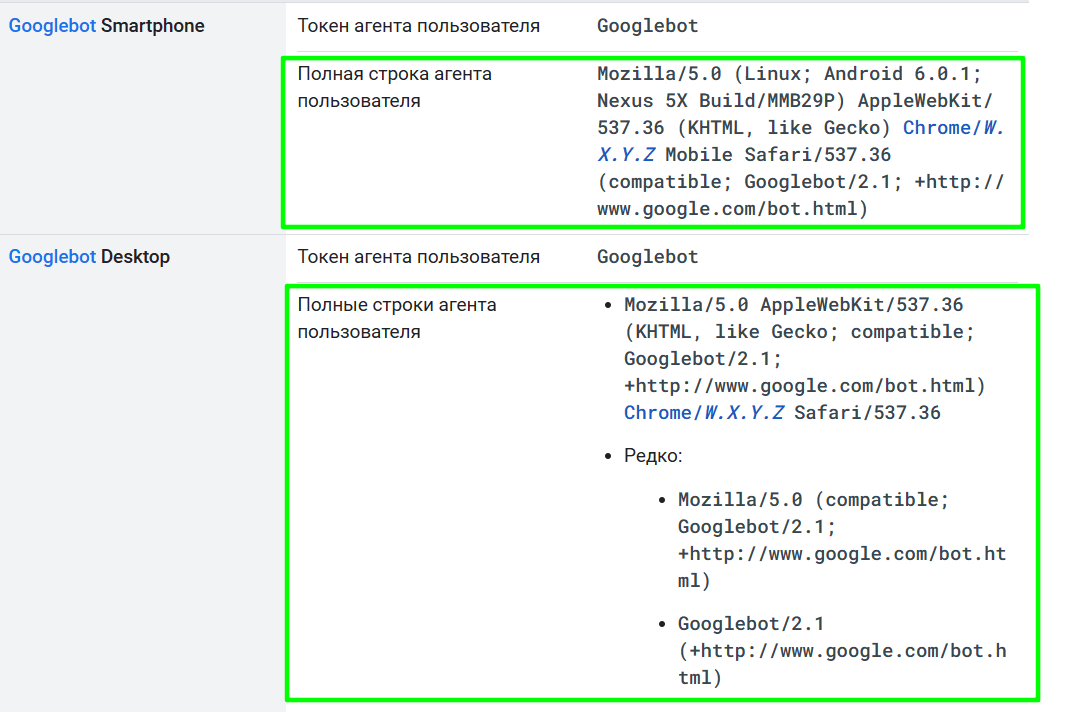

В клоакинге User-Agent применяют как самый простой способ идентификации посетителей. Если в строке данных присутствует имя поискового робота, откроется вайт пейдж. Для запуска подмены нужно знать имена роботов и прописать их в настройках.

Пример User-Agent некоторых поисковых роботов Google. Источник

IP-адрес

IP-адрес (Internet Protocol address) — это уникальный числовой идентификатор устройства, которое подключено к компьютерной сети. Когда посетитель заходит на сайт, то его IP-адрес отправляется серверу, чтобы он мог отправить данные в ответ.

Использование IP-адресов в клоакинге считается одним из наиболее эффективных способов, поскольку их довольно сложно сфальсифицировать. Поисковых роботов определяют по числовому идентификатору, и в зависимости от IP-адреса показывают подходящую версию страницы. Как правило, IP-адреса ботов и фильтр-систем собирают вручную или покупают.

Некоторые IP-адреса поисковых ботов есть в открытом доступе. Источник

Иногда применяют комбинированный клоакинг, в котором сочетают проверки User Agent и IP-адресов. Этот способ более трудоемкий, но результативный.

Трекеры для арбитражника

Настройку клоакинга через трекеры часто используют в арбитраже трафика. Трекеры — это специальные платформы, которые собирают и анализируют различные метрики в режиме реального времени. С их помощью отслеживают данные о пользователях — устройства, операционную систему, гео и другие характеристики. Также можно определять ботов.

В настройках трекера задают параметры для разделения трафика. В результате система уводит ботов и модераторов на вайт пейдж с нужной оптимизацией, а остальной аудитории показывает целевую страницу. При этом большинство сервисов формирует отчёты об анализе и распределении трафика.

С помощью трекера на одну ссылку можно «привязать» несколько разных страниц

Процесс установки трекера зависит от его типа — серверного или облачного. В первом случае систему устанавливают на собственный сервер и распаковывают системные данные. Во втором — все процессы происходят онлайн и ничего устанавливать не нужно.

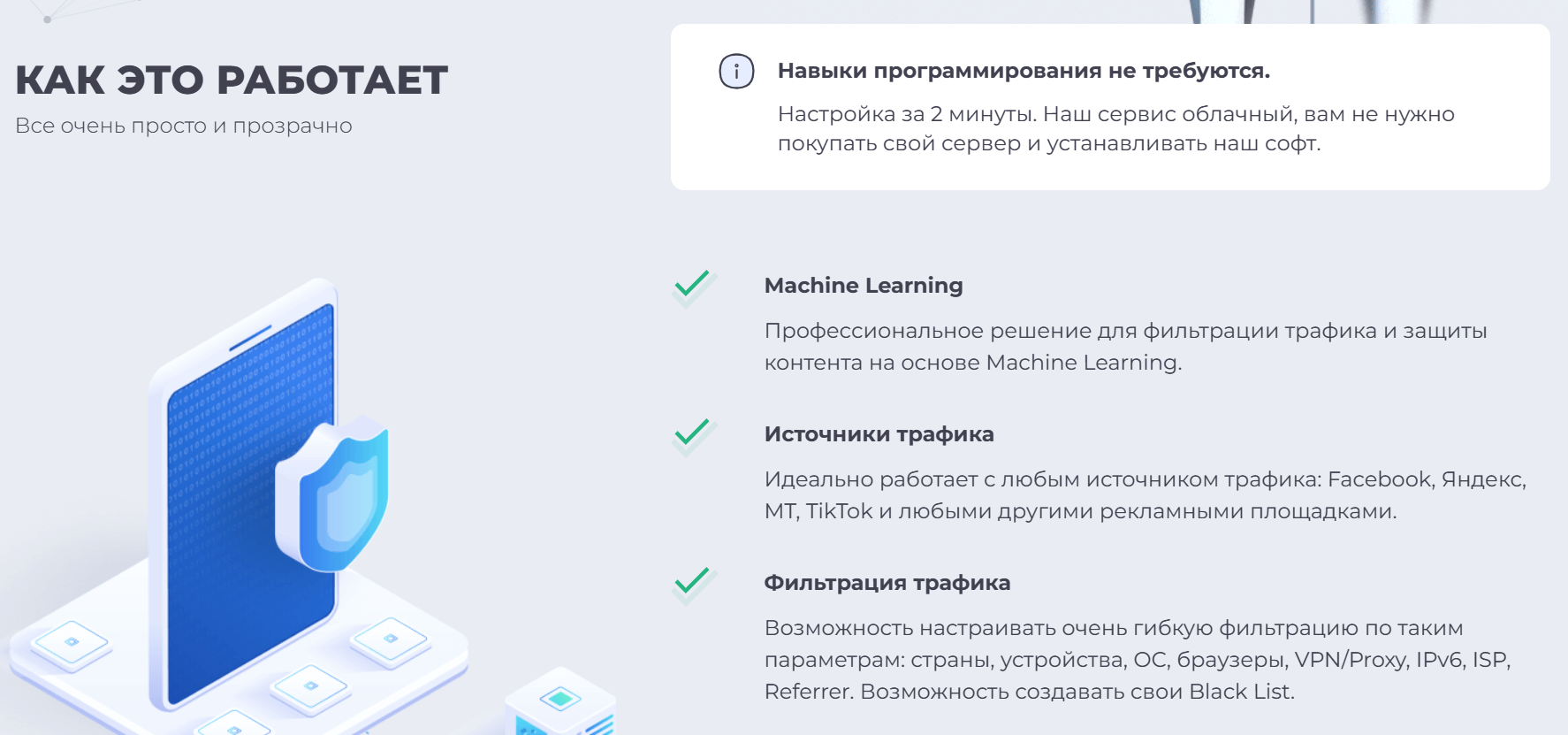

Сервисы для создания клоакинга

Сервисы для клоакинга позволяют работать в арбитраже без трекеров. Разделение трафика происходит за счёт использования JS-скриптов, которые устанавливают на целевую страницу.

Такие сервисы самостоятельно собирают базу «нежелательных» адресов — IP-адреса ботов и модераторов. Все посетители из этой базы попадают на вайт пейдж. Обычные пользователи видят целевую страницу.

Принцип работы сервиса состоит в том, что после регистрации веб-мастер скачивает и устанавливает на свой сайт сгенерированный скрипт. Этот скрипт позволяет перенаправить ботовый трафик на страницу с оптимизацией.

Принципы работы сервиса для клоакинга

Сервисы для клоакинга отличаются от трекеров тем, что умеют самостоятельно собирать и обрабатывать базы данных.

Главные мысли